編輯與審核 –

Anuj Saini

(數據科學總監, RPX)

大型語言模型 (LLMs),例如 GPT 和 BERT,正在引領人工智慧的世界。

這些模型能夠理解和生成類似人類的文字,使它們在許多現實應用中非常有價值,從聊天機器人到內容創作。

然而,部署和管理這些模型並不容易。

這需要一系列步驟,以確保它們從創建到實際使用的過程中都能順利且合乎道德地運行。

本指南將帶您了解管理 LLM 的完整過程,涵蓋從部署和更新到監控性能和確保公平性的一切。

理解大型語言模型 (LLMs)

什麼是 LLMs?

大型語言模型 (LLMs) 是強大的人工智慧 (AI) 系統,旨在理解、生成和回應人類語言。

這些模型是使用各種文本數據構建的,並經過訓練以執行各種任務,例如回答問題、翻譯語言、撰寫內容,甚至進行對話。

一些流行的 LLM 例子包括:

GPT (生成預訓練變壓器):由 OpenAI 創建的模型,以其生成類似人類的文本能力而聞名。

BERT (雙向編碼器表示法):由 Google 開發的模型,專注於理解句子中單詞的上下文。

LLMs 的目的

LLMs 有幾個重要的目的,特別是在商業和技術領域。以下是它們的幫助方式:

1. 提升商業 KPI (關鍵績效指標):

LLMs 可用於改善商業成果,例如提高客戶滿意度或擴大銷售。最知名的模型知道它們可以自動化客戶支持、進行客戶反饋分析,甚至創建市場行銷內容。

2. 推動 AI 應用的創新:

LLMs 推動了 AI 能做的事情的邊界。它們是許多令人興奮的技術的核心,例如聊天機器人、虛擬助手、自動內容創作,甚至是幫助創意領域(如寫作、音樂或藝術)的工具。

運行 LLMs

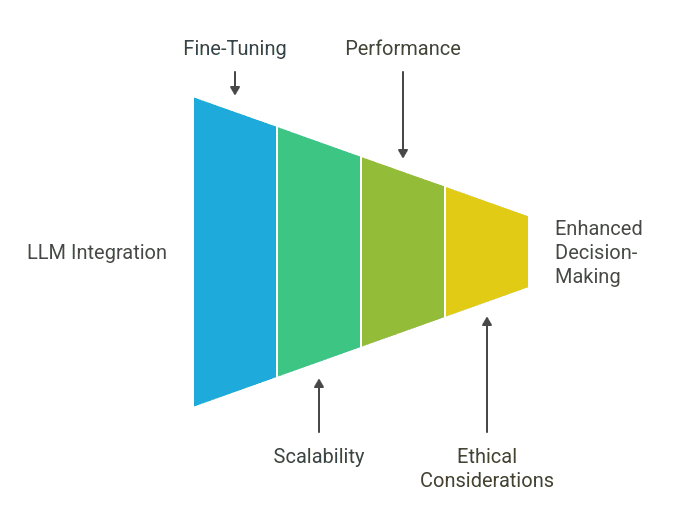

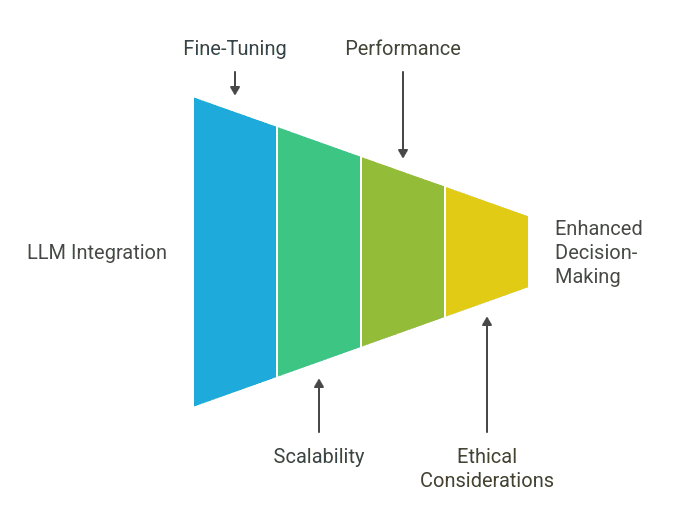

在現實應用中部署 LLMs

一旦大型語言模型 (LLM) 開發和訓練完成,下一步就是讓模型對用戶或其他系統可用,以便它可以開始執行任務,例如回答問題或開發內容。

從開發到部署:

在開發階段,LLMs 通常在 Jupyter 筆記本等環境中進行測試,數據科學家在這裡實驗模型。

部署模型的一種常見方法是使用 API (應用程式介面),這使其他軟體能與模型進行通信。例如,網站或應用程式可以訪問模型以實時生成回應。

Flask 是一個流行的 Python 框架,通常用於創建可以通過 API 服務 LLMs 的網頁應用程式。

部署的關鍵考量:

可擴展性:模型應能管理不斷增長的用戶數量,而不會變慢或崩潰。

延遲:模型必須快速回應。高延遲和回應延遲可能會導致用戶失去興趣。

用戶可訪問性:模型應易於用戶互動,無論是通過聊天機器人、虛擬助手還是內容生成工具。

刷新和更新模型

LLMs 需要定期更新以保持準確性。隨著新數據的進入,模型從舊數據中學到的模式可能會改變,模型的表現可能會下降。因此,模型刷新是必不可少的。

為什麼刷新是必需的:

隨著時間的推移,數據模式可能會改變,這表明模型可能無法理解最新的數據。

刷新步驟:

管道自動化:自動化更新模型的過程對於加快刷新過程至關重要。這可以通過設置自動化管道來完成。

版本控制:跟蹤不同版本的模型非常重要。當模型被刷新時,會創建新版本,以便可以比較舊版本並在需要時切換回去。

平穩退役舊模型:在更新模型時,應平穩退役舊版本,以避免與仍在互動的用戶發生問題。

監控 LLM 性能

在部署和刷新 LLMs 之後,持續觀察模型在現實應用中的運行狀況至關重要。

監控工具如 MLflow:

像 MLflow 這樣的工具有助於通過提供儀表板和分析來跟蹤模型的實施情況。這些工具顯示模型的運行效果以及是否需要進行一些調整。

跟蹤關鍵指標和檢測模型漂移:跟蹤準確性、回應時間和用戶參與度等指標至關重要,以確保模型持續滿足期望。

模型漂移:隨著時間的推移,模型可能會因為訓練數據不再準確而表現變差。及早檢測這種漂移並重新訓練模型對於保持性能至關重要。

LLMs 的 MLOps

什麼是 MLOps?

MLOps 將 DevOps 和機器學習實踐結合起來,以管理模型的生命周期。它簡化了從開發到部署和監控的過程,確保模型可靠、可擴展並持續改進。

將 DevOps 原則應用於機器學習:

MLOps 將 DevOps 實踐應用於機器學習,自動化數據收集、模型訓練、測試、部署和監控等任務。這幫助團隊有效地管理大規模的機器學習專案。

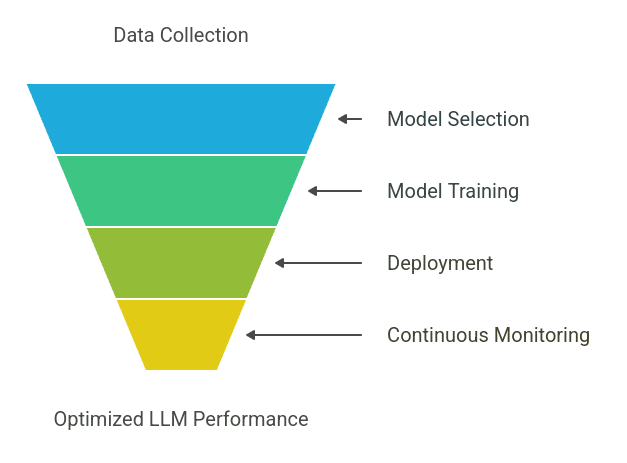

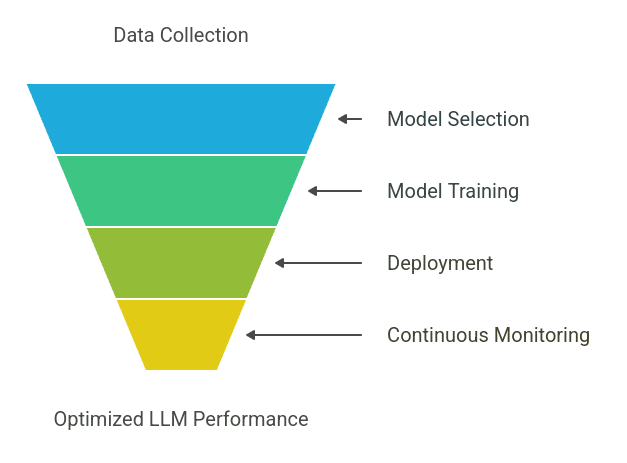

MLOps 生命週期的組成部分

MLOps 涵蓋機器學習模型的完整生命週期,確保其不斷發展並保持最佳性能:

數據收集和準備:收集和清理數據是生命週期的第一步。這包括確保數據對於訓練模型是相關和高質量的。

模型選擇、微調和評估:選擇合適的機器學習模型至關重要。選定後,使用訓練數據對其進行微調以提高性能。

部署和持續監控:模型部署後,持續監控確保其按預期運行。這會跟蹤準確性、回應時間和用戶反饋等指標,並進行必要的調整。

LLMs 的 CI/CD 管道:持續集成 (CI) 和持續交付 (CD) 管道在 MLOps 中至關重要,自動化機器學習模型的集成和部署。

CI/CD 的重要性

持續集成:自動測試和集成代碼變更,確保系統保持穩定。

持續交付:自動將代碼變更部署到生產環境,提高速度和可靠性。

建立有效的管道:CI/CD 管道應支持測試、預備和生產環境,確保模型在實際部署前在每個階段正常運行。

容器化:容器化是 MLOps 中的一項重要實踐,特別是對於部署大型模型如 LLMs,使用 Docker 等工具打包整個模型生態系統。

打包整個模型生態系統:容器包括模型、依賴項、配置和必要的環境,確保無論部署位置如何,行為一致。

確保各環境的一致性:容器保證模型在所有環境中(如開發、測試、預備和生產)表現一致,使部署可靠且可預測。

道德和負責任的 AI 實踐

隨著大型語言模型 (LLMs) 的廣泛使用,確保負責任的 AI 實踐變得非常重要。關鍵要素包括:

1. 解決偏見:AI 模型可能會從訓練數據中繼承偏見,導致不公平的結果。識別和減輕這些偏見在訓練和輸出中至關重要。

2. 確保公平性和問責制:AI 系統必須公平、透明且可問責。企業應確保其模型對用戶是可解釋和可信的。

3. 生成 AI 的護欄:生成 AI,如 LLMs,具有濫用的潛力,特別是在開發有害或欺騙性內容時。為了防止風險的可能性,實施保護措施至關重要:

4. 防止濫用:AI 系統應具備保護措施,如審核工具,以阻止有害或冒犯性內容,確保道德輸出。

5. 平衡準確性和道德:AI 模型必須在高準確性和道德考量之間取得平衡,調整輸出以符合社會價值,即使這會稍微影響性能。

6. 遵循法規:隨著 AI 的發展,全球標準確保負責任的使用。遵守法規對於建立信任和道德發展至關重要。

7. 數據隱私和 AI 道德:AI 必須遵循數據隱私法(例如 GDPR)和道德準則,確保負責任地處理個人數據並遵循當地法規。

建議閱讀:AI 道德與發展

LLM 管理的未來趨勢

1. 技術進步

LLMs 的演變受到持續技術創新的驅動。隨著 LLMs 變得更加複雜,新發展正在改善它們的能力:

2. 驅動 LLM 演變的創新:

更高效的架構:新架構使 LLMs 在訓練時間和資源使用方面更加高效。

更好的訓練方法:訓練技術的創新,如轉移學習和無監督學習,正在改善模型性能和可擴展性。

3. 企業和監管機構對道德 AI 的日益重視:

企業面臨來自監管機構和消費者的越來越大壓力,要求確保其 AI 系統是道德的、透明的,並與社會價值相符。

這一趨勢促使企業在 AI 開發的每個階段(從設計到部署)都融入道德考量。

結論

管理大型語言模型 (LLMs) 需要一種全面的方法,將尖端技術與道德考量相結合。

通過遵循負責任的 AI 實踐,企業可以確保部署的 LLMs 不僅有效,而且公平和透明。

隨著 AI 的發展,採用自動化和道德發展趨勢對於保持競爭力至關重要。

對於那些希望掌握這些進展並學習如何管理尖端 LLMs 的人,考慮報名參加 Great Learning 的 AI 和 ML 課程,該課程涵蓋 AI 的技術和道德兩方面,為您在這一領域的成功職業做好準備。

本文由 AI 台灣 運用 AI 技術編撰,內容僅供參考,請自行核實相關資訊。

歡迎加入我們的 AI TAIWAN 台灣人工智慧中心 FB 社團,

隨時掌握最新 AI 動態與實用資訊!